QUALIDADE: VISÃO GERAL

Hoje em dia é muito comum que nos preocupemos que os produtos e serviços que compramos tenham qualidade. Mas o que é qualidade? Geralmente, associamos qualidade ao fato do produto servir para aquilo que ele se propõe, funcionando perfeitamente, mas essa não é a única visão que se tem sobre o assunto.

Vejamos um exemplo específico: algumas pessoas podem dizer que um telefone celular com baixa qualidade é um aparelho que não funciona bem, que o sinal fica caindo, que a bateria dura pouco, que quebra na primeira queda, etc. Partindo da percepção desses consumidores, a empresa que fabrica telefones celulares deve se preocupar em fabricar um aparelho robusto, que não quebre na queda e que tenha bateria durável e uma antena interna potente. Trata-se da qualidade com foco no produto, mas ainda existem outras, que veremos nas próximas páginas...

- Mas como a empresa busca criar esses produtos de qualidade?

Você precisa entender que, ao longo da história, o trabalho do buscar qualidade na produção variou bastante. Até a Revolução Industrial, a produção de bens e serviços para o mercado era feita por artesãos, que conheciam perfeitamente as necessidades de seus consumidores e atuavam ao longo de todo o processo produtivo, da concepção do produto até a sua entrega ao cliente.

Um produtor de sapatos, neste contexto, teria que medir o tamanho dos pés de cada cliente, definir como o produto deveria ficar depois de pronto, comprar o couro e a madeira para usar como matéria prima básica, cortar, costurar e colar as partes, e realizar todo o resto do processo produtivo para inspecionar cada produto que foi feito e saber se ele possui ou não a qualidade esperada pelo cliente. Como você observou, nessa época, o controle de qualidade envolvia o foco no produto e naquilo que era esperado pelo cliente no final. Havia uma inspeção de cada produto ao final do processo de produção, para se verificar se estava como esperado.

Isso é diferente de como as coisas acontecem hoje em dia!

Com o advento da revolução industrial, isso se tornou mais difícil. A introdução da máquina no processo produtivo fez com que surgissem as fábricas, que passaram a realizar a produção em larga escala. A produção deixava de ser customizada de acordo com as necessidades de cada cliente e o artesão era substituído pelo operário do chão de fábrica. É nessa época que surgem os autores clássicos da teoria da administração, Taylor e Fayol, enfocando a divisão de tarefas e a estruturação da organização. Os trabalhadores passam a dominar apenas uma parte do trabalho total feito pela organização. Assim, em oposição ao trabalho de um artesão, um trabalhador em uma fábrica de sapatos passava a se especializar em apenas uma tarefa na produção de sapatos, como cortar o couro com os moldes, por exemplo.

Num primeiro momento, para controlar a qualidade, tentou-se realizar a inspeção de todos os produtos no final da linha de produção, o que serviu como pano de fundo para o início dos estudos sobre qualidade. Como os indivíduos não eram mais os únicos responsáveis pelo produto final, não havia como controlar a qualidade unicamente na saída da fábrica. Surge a figura do inspetor de qualidade que começa a levar em consideração o processo produtivo, a padronização de peças e tarefas.

Com o passar do tempo, outros elementos passaram a ser adicionados à visão de qualidade que a organização tinha que ter: especificação, tolerância, conformidade, controle estatístico, etc.

Na verdade, é possível dizer que a qualidade nas organizações passou por diferentes eras ao longo do tempo, havendo intercessões e complementaridade entre cada uma dessas eras. Vamos ver as características centrais de cada uma dessas eras:

Como você pôde ver no quadro anterior, cada era da qualidade representou um interesse diferente por parte da organização. Hoje em dia, as ideias de qualidade das diferentes eras ainda se fazem sentir pelas organizações, em especial a gestão da qualidade total e o impacto estratégico que ela pretende gerar.

Agora eu retomo a pergunta que fiz no início da aula: o que é qualidade?

R.: Na verdade, qualidade é um construto complexo, que pode ser percebido de diferentes maneiras, as principais são:

-

Abordagem transcendental: para esta visão, qualidade é o mesmo que excelência. Significa fazer o melhor que se pode fazer. Essa abordagem é de difícil aplicação prática, uma vez que não se pode medir "o melhor que é possível fazer" . O cliente veria como possuidor de qualidade aquele produto que foi feito da melhor forma possível. Fala-se ainda que, por produzir o melhor que se pode fazer, esta qualidade seria reconhecida por todos, de maneira universal. Obras de arte de valor inestimável são percebidas dessa forma.

-

Abordagem baseada no produto: trata-se de uma visão que considera que a qualidade é uma variável que pode ser medida a partir dos atributos do produto. O problema é que nem sempre os atributos representam nitidamente a "qualidade". Quem já ouviu falar das antigas propagandas das sandálias Havaianas: "não deforma, não solta as tiras e não tem cheiro". Para eles, a qualidade estava nos atributos do produto! Será que hoje em dia isto faria algum sentido? Provavelmente não!

-

Abordagem baseada no usuário: nesta percepção, criada por Juran e Gryna, qualidade é uma variável subjetiva que atende às demandas do consumidor. Um produto de qualidade é aquele que serve para o que o consumidor quer, possuindo elevada adequação ao uso, o que é muito bem aceito pelos profissionais de qualidade hoje em dia. Para alguém que precise de um computador, mas necessite também de elevada mobilidade, de nada adiantará lançar um novo notebook superpotente que pese muito e seja enorme. Não servirá para o usuário.

-

Abordagem baseada no valor: para essa abordagem, um produto de qualidade é aquele que oferece valor para o consumidor, que é a relação entre o quanto o consumidor valoriza aquele produto pelo o que ele proporciona com o custo que se incorre para possuí-lo. O problema é que é um conceito de difícil aplicação, pois os conceitos envolvidos são, por si só, complexos, e misturá-los aumenta esta complexidade. A abordagem dá ênfase à engenharia/Análise de valor. Um produto de alta qualidade (valor) seria aquele que apresenta a melhor relação custo x benefício para o consumidor.

-

Abordagem baseada na produção: Para essa abordagem, a qualidade é a conformidade às especificações. Ainda na concepção do produto, suas especificações são pré-determinadas e haverá qualidade se elas forem cumpridas. Trata-se de um conceito mais ligado ao controle pelo uso de ferramentas estatísticas.

De outra forma, pode-se falar na existência das seguintes dimensões para a qualidade:

-

Durabilidade: vida útil do produto antes que ele se deteriore.

-

Conformidade: está ligada ao quanto os produtos estão de acordo com as especificações técnicas (qualidade planejada), sendo relacionada com padronização e variabilidade na produção.

-

Desempenho: é a dimensão ligada a se o produto realmente funciona como esperado com base em suas características principais.

-

Características secundárias: são os elementos "a mais" que o produto oferece, além de suas características principais.

-

Confiabilidade: diz respeito à possibilidade de mau funcionamento de um produto ao longo do tempo, tanto em termos de qualidade do serviço/produto, tempo ou outros componentes. Quanto menor esta possibilidade de falhas, mais confiável.

-

Assistência técnica: é a qualidade na prestação de reparos aos problemas e reclamações.

-

Estética: são as características percebidas pelo ser humano como "bonitas", tais como cheiro, som, aparência, etc.

-

Qualidade percebida: é a qualidade que o cliente atribui ao produto, de forma geral.

-

Resposta: é a qualidade no tratamento com o cliente para oferecimento de respostas, tais como profissionalismo, educação, cortesia, pontualidade, etc.

Agora que você já entende as várias formas de se perceber qualidade, vamos estudar quais são os principais teóricos desse ramo de estudos e as suas contribuições para a gestão da qualidade.

2. PRINCIPAIS TEÓRICOS DA QUALIDADE E SUAS CONTRIBUIÇÕES

São vários os teóricos que contribuíram para o estudo da qualidade. Vamos aqui abordar os principais teóricos maior abrangência.

2.1. WALTER SHEWHART

Americano formado em engenharia e com doutorado em física, Shewhart trabalhou na Western Electric Company e levou sua experiência para a Bel/ Telephone Laboratories.

Em 1924, já trabalhando na Bell, Shewhart revolucionou a utilidade das inspeções de qualidade nas organizações. Acontece que, até então, as inspeções de qualidade serviam apenas para identificar os produtos com defeito e tirá-los da linha de produção. Nesse sentido, Shewhart trabalhou na criação de uma ferramenta para a análise estatística dos problemas em um determinado processo, chamada de gráfico de controle/carta de controle.

Trata-se de uma ferramenta simples que realiza uma análise gráfica das variações nos processos monitorados. Com ela, é possível visualizar facilmente as variações comuns e normais em um processo, abrindo a possibilidade de identificar variações que demonstram descontrole nos processos e investigá-las. Vejamos um exemplo desse gráfico.

Essa ferramenta é utilizada até hoje nas organizações, sendo uma das ferramentas de qualidade mais importantes.

Você deve ter em mente ainda que, com o desenvolvimento dessa ferramenta, Shewhart tornou se conhecido como o pai do controle estatístico da qualidade/controle estatístico de processos.

- Mas não é só isso!

Shewhart também foi responsável pelo desenvolvimento inicial do ciclo PDCA (Plan, Do, Check, Act) de melhoria contínua, que foi aperfeiçoado e difundido em um segundo momento, em conjunto com William Edwards Deming, um discípulo de seu trabalho que também ofereceu grandes contribuições para a qualidade.

Prestem atenção: Shewhart e Deming foram tão fundamentais para o Ciclo PDCA que este é chamado também de Ciclo de Shewhart ou Ciclo de Deming. É bom saber ainda que o PDCA vem sendo aplicado em várias áreas diferent es da organização - indo além da qualidade.

Shewhart tornou-se conhecido como o pai do controle estatístico da qualidade/ controle estatístico de processos, além de ter sido o responsável pelo desenvolvimento inicial do ciclo PDCA.

2.2. WILLIAM DEMING

Engenheiro americano nascido em 1900, Deming viveu até 1993, tendo contribuído bastante para o estudo da qualidade ao longo de sua vida.

Foi, contudo, durante o período do pós-2a Guerra Mundial que ele realizou suas maiores contribuições. Em 1947 ele foi enviado para o Japão como especialista em técnicas estatísticas de amostragem para ajudar na reconstrução. Permanecendo por alguns anos naquele país, Deming incorporou alguns conceitos culturais japoneses à sua visão de qualidade, percebendo a importância da participação dos trabalhadores e do envolvimento da alta administração em uma atitude de melhoria contínua, também chamada de kaizen.

Ele acreditava que as decisões da gerência eram responsáveis por 85% dos problemas de produção, já que elas são responsáveis pelo funcionamento do processo. Assim, 85% dos erros são originários do próprio sistema produtivo e seus processos, enquanto os erros oriundos de decisões dos trabalhadores representam apenas 15% do total. Essa observação passou a ser conhecida como regra dos 85 - 15%.

Ele percebeu ainda a importância do uso da ferramenta PDCA para a melhoria contínua em toda a organização, pois ela se adaptava perfeitamente ao propósito de melhoria na qualidade dos produtos e processos da organização no contexto japonês. A ideia era buscar uma redução contínua dos desperdícios, dos custos e dos retrabalhes no processo produtivo para obter melhorias na qualidade.

Deming foi ainda consultor do Sindicato de Cientistas e Engenheiros Japoneses (chamado de JUSE Japanese Union of Scientists and Engineers) durante vários anos, o que possibilitou que suas técnicas e visão de qualidade fossem difundidas por todo o Japão. A propósito, o reconhecimento de Deming e tão grande no Japão que o Prêmio Nacional de Qualidade (do Japão) leva o seu nome: Prêmio Deming de Qualidade!!

Além de acreditar que a qualidade deve ser balizada na busca das necessidades do cliente, Deming contribuiu para a gestão da qualidade com base na sua percepção da necessidade de mudança organizacional (através da melhoria contínua) e participação de todos para a melhoria contínua. Para isso, ele elaborou uma lista dos 14 pontos que sintetizavam suas ideias sobre qualidade, conhecida como "os 14 Pontos de Deming", e que constituem uma importante base para o movimento de Gerenciamento da Qualidade Total (TQM). Com base nestes princípios, as empresas ocidentais poderiam realizar a melhoria contínua na qualidade de suas operações. Esta lista está apresentada a seguir, com destaques feitos por mim para que você memorize o que é mais importante. Vejamos os 14 pontos de Deming (DEMING, apud CARVALHO, 2005):

-

Crie constância de propósitos em torno da melhoria de produtos e serviços buscando tornar-se competitivo, manter-se no negócio e gerar empregos.

-

Adote uma nova filosofia. Estamos em uma nova era econômica. Gerentes ocidentais precisam assumir o desafio, aprender suas responsabilidades e liderar o processo de mudança.

-

Acabe com a dependência da inspeção como forma de atingir a qualidade. Elimine a necessidade de inspeção em massa, construindo a qualidade do produto em primeiro lugar.

-

Elimine a prática de priorizar negócios com base no preço. Pense em minimizar o custo total. Caminhe no sentido de um único fornecedor para cada item e estabeleça um relacionamento de longo prazo, baseado na lealdade e na confiança.

-

Melhore constantemente o sistema de produção e de serviços, aprimorando a qualidade e a produtividade, e assim sempre diminuindo os custos.

-

Estabeleça o treinamento no trabalho (on the job).

-

Estabeleça a liderança (veja ponto 12). O objetivo da supervisão deve ser ajudar trabalhadores e máquinas a fazer o trabalho melhor.

-

Elimine o medo, assim todos podem trabalhar efetivamente para a organização.

-

Quebre as barreiras entre os departamentos. Pessoal de pesquisa, projeto, vendas e produção devem trabalhar juntos, como uma equipe.

-

Elimine os slogans, exortações e metas para a forca de trabalho, tais como defeito zero (zero defects) e novos níveis de produtividade. Tais exortações apenas criam um ambiente de adversidade, pois as causas da baixa qualidade e produtividade pertencem ao sistema, indo além do poder da força de trabalho. * Elimine as quotas de trabalho no chão-de-fábrica. Substitua por liderança. *Elimine gerenciamento por objetivos. Elimine gerenciamento por números e metas numéricas. Substitua por liderança.

-

Remova barreiras que impedem os trabalhadores de sentirem orgulho do seu trabalho.

-

Remova barreiras que impedem os gerentes e engenheiros de sentirem orgulho de seu trabalho. Isso significa abolir os índices anuais ou de mérito por objetivos.

-

Institua um vigoroso programa de educação e auto melhoria.

-

Envolva todos da organização na tarefa de alcançar a transformação. A transformação é tarefa de todos.

Note como muitos desses pontos são atuais e até hoje utilizados em muitas organizações ao redor do mundo.

Revise com atenção os 14 pontos de Deming.

Além desses 14 pontos, Deming também estabeleceu as sete doenças fatais da administração que, segundo ele, seriam (Meireles, 2001):

-

Falta de constância de propósitos: sem constância de propósito não se pensa no longo prazo.

-

Ênfase nos lucros a curto prazo: o lucro deve ser planejado para agora e sempre. Lucros de curto prazo podem sacrificar a organização.

-

Administração pelo medo: avaliações de desempenho individuais estimulam desempenho de curto prazo, e não de longo prazo.

-

Administração com grande mobilidade: os administradores precisam se comprometer com o longo prazo. A troca constante de diretores é algo ruim.

-

Ênfase nos valores numéricos: valores qualitativos podem expressar melhor a qualidade dos produtos e serviços, ao invés de métricas numéricas.

-

Custo exagerado da assistência médica: agravados por honorários de risco para advogados.

-

Custo exagerado de garantias: agravados por honorários de risco para advogados.

Meireles (2001, p. 50) destaca, entretanto, que as duas últimas doenças seriam pertinentes apenas aos Estados Unidos. Por isso, é relativamente comum que as referências teóricas também se deem às cinco doenças fatais da administração de Deming, referindo-se apenas às 5 primeiras.

2.3. JOSEPH JURAN

Romeno nascido em 1904, Juran estudou engenharia e direito, sendo um dos grandes gurus do estudo da qualidade nas organizações. Ele via a qualidade como a adequação dos produtos aos usos pretendidos.

Havendo trabalhando na Western Electric Company (assim como Shewhart), ele t am bém participou dos esforços para a reconstrução do Japão no pós-guerra (assim como Deming).

Juran considerava a existência de custos de qualidade de diferentes naturezas. Para ele, os custos da prevenção da qualidade e da avaliação da qualidade eram inevitáveis, pois a organização precisaria incorrer neles para garantir a qualidade. Por outro lado, ele destacava a existência de custos de qualidade evitáveis, que seriam de grande valia para a organização. Os custos evitáveis seriam os custos de falhas (internas e externas). Internamente, fatores como o retrabalho, desperdício, repetição de testes e perdas de produtividade são custos da não qualidade. Externamente, fatores como a falta de competitividade de seus produtos e o comprometimento da imagem da organização também representam custos da não qualidade.

Juran foi um dos grandes impulsionadores da gestão da qualidade total no Japão, em conjunto com Deming. Ele acreditava que a conscientização seria o caminho para que resultados fossem obtidos. Definia ainda planejamento como o estabelecimento de metas, planos e responsabilidades a fim de obter os resultados.

Ao longo de sua vida, esse autor escreveu diversos livros sobre qualidade, onde se destacam os seguintes conceitos:

-

Noção de que o cliente (interno e externo) é quem "puxa" a produção na organização;

-

Proposição da trilogia da qualidade:

-

Planejamento da qualidade - através do estabelecimento de objetivos e planos de ação.

-

Controle da qualidade - comparação entre o desempenho operacional real e o que foi planejado.

-

Melhoria da qualidade - aperfeiçoamento do desempenho rumo a um patamar superior de qualidade que faz com que a organização se torne mais competitiva.

-

2.4. ARMAND FEIGENBAUM

Engenheiro nascido em 1922 nos Estados Unidos , Feigenbaum ficou conhecido por ser o primeiro autor a falar em Controle da Qualidade Total (TQC - Total Quality Contral).

Ainda na era do controle estatístico, Feigenbaum afirmava ainda que a qualidade deveria ser conduzida por especialistas em controle da qualidade, em um departamento de controle da qualidade. Apesar disso, reconhecia que esse departamento especializado deveria ter outras atribuições típicas de assessoria, já que os demais departamentos e áreas da organização também deveriam ter uma parcela de responsabilidade na qualidade de seus processos. O que ele pretendia era mudar a ênfase da correção para a prevenção de defeitos, ou seja: fazer certo da primeira vez.

Posteriormente, já na era da qualidade total, ele entendeu que a qualidade teria que ser embutida no produto ou serviço desde o começo, a partir dos desejos e interesses dos clientes, e que todos os funcionários e áreas seriam responsáveis pela qualidade. As ideias de controle da estatístico da dispersão dos dados seguiu com Feigembaum mesmo nessa era.

Ainda assim, o controle da qualidade deve se dar com o apoio central de um departamento de qualidade, com especialistas das áreas. Com isso, a qualidade (já no TQC) deixa de ser responsabilidade exclusiva do departamento de qualidade.

Para ele, TQC poderia ser definido como um sistema efetivo para integrar os esforços de desenvolvimento, manutenção e melhoramento da qualidade dos vários grupos em uma organização, de modo a possibilitar produção e serviços no nível mais econômico possível, o que permitiria a satisfação das expectativas do cliente.

2.5. PHILIP CROSBY

Para Crosby, que era engenheiro e nasceu em 1926 nos Estados Unidos, a qualidade era representada pela conformidade às especificações. Ele acreditava que o projeto deveria guiar a qualidade nas organizações.

Com base nisso, ele lançou o Programa Zero Defeito. uma das suas maiores contribuições para a gestão da qualidade. A ideia central era que se deveriam evitar os custos da não qualidade, fazendo corretamente o que tem que ser feito desde a primeira vez. Tornando-se bastante popular, o programa Zero Defeito foi utilizado tanto em programas militares (em 1961 - na construção de mísseis), quanto nas empresas, já que Crosby passou a atuar como consultor, o que facilitava a difusão de suas ideias.

Além disso, Crosby também propôs um plano para melhoria da qualidade nas organizações, pois considerava que a qualidade era um investimento. Esse plano era constituído por 14 pontos, conforme apresentado a seguir:

-

Comprometimento da alta gerência: a alta gerencia deveria ser comprometida com a qualidade. Para isso, a propositura de uma política de qualidade era muito importante, pois demonstraria para toda a organização esse comprometimento.

-

Instalação de equipes de melhoria de qualidade: as equipes de melhoria da qualidade são às bases para o bom andamento do programa de melhoria da qualidade. Elas deveriam ser instaladas em todos os setores da empresa.

-

Mensuração da qualidade: a qualidade deveria ser medida e calculada de modo a gerar indicadores de qualidade que servissem para indicar as necessidades de melhoria. Os registros de não conformidades deveriam ser um importante insumo para isso.

-

Levantamento dos custos da não-qualidade: o levantamento dos custos da falta de qualidade tira o conceito do abstrato e coloca em uma perspectiva financeira, fácil de ser percebida pela organização. Assim, evitar esses custos torna-se uma medida de lucro mensurável para a empresa.

-

Conscientização dos membros da organização: todos os funcionários da organização devem estar conscientes da importância da qualidade nos produtos e serviços da mesma.

-

Implantação de um sistema de ação corretiva: a ação corretiva é fundamental para que os problemas identificados possam ser resolvido s. Para Crosby tratam-se de simples correções que podem gerar ganhos significativos.

-

Planejamento do Programa de Zero Defeito: a organização deve procurar acertar as coisas na primeira vez, evitando os custos da não qualidade.

-

Treinamento dos inspetores e outros responsáveis pela qualidade: os programas de melhoria de qualidade teriam sucesso com base naqueles que o conduzem, então seria fundamental que os responsáveis pela qualidade na organização fossem devidamente treinados.

-

Estabelecimento do dia Zero Defeito: trata-se da instauração de um marco para o Programa de Zero Defeito, utilizado de forma a conscientizar e envolver todos na organização em torno do Programa.

-

Fixação de objetivos/metas a serem alcançados: trata-se de fixar os resultados a serem alcançados para cada equipe, selecionando as medidas de desempenho que refletem essa melhoria.

-

Eliminação das causas dos erros: trata-se de agir sobre as causas dos problemas para evitar que eles continuem a acontecer.

-

Reconhecimento público dos resultados obtidos pelas pessoas: as pessoas querem se sentir valorizadas pela organização, e isso não se consegue através de prêmios financeiros. O ideal é que o bom desempenho seja publicamente reconhecido para que as pessoas se motivem e se envolvam com o programa.

-

Instalação dos círculos de qualidade: trata-se da instauração de pequenos grupos de voluntários que devem se reunir periodicamente com o propósito de monitorar a qualidade em cada área da organização.

-

Reiniciar o ciclo: após todas as etapas acima, o último passo seria reiniciar o ciclo a partir da primeira atividade, para que o programa de qualidade seja contínuo na organização.

2.6. KAROU ISHIKAWA

Japonês nascido em 1915 e formado em química aplicada, lshikawa era professor e consultor de empresas.

Dentre suas principais contribuições para o estudo da qualidade destaca-se a formulação do Controle de Qualidade por toda a Empresa (Company Wide Quality Contrai -CWQC), que considerava que o controle de qualidade deveria ser realizado por toda a empresa e com a participação de todos, ao contrário do mecanismo do TQC de Feigenbaum, que valoriza o papel do departamento de qualidade.

Além disso, lshikawa foi um dos grandes responsáveis pela difusão das sete ferramentas da qualidade, que viriam a ser bastante utilizadas pelos Círculos de Controle da Qualidade (CCQs), sendo bastante relevantes até hoje nas organizações.

Para que você saiba desde já, os CCQs são pequenos grupos de funcionários voluntários que atuam em busca de melhorar a qualidade dos processos diretamente relacionados aos seus trabalhos. Uma organização com o modelo japonês de qualidade possui CCQs nas diversas partes da organização. Eles servem ainda para gerar maior compromisso dos funcionários com a qualidade na organização.

As sete ferramentas da qualidade difundidas por lshikawa são as seguintes:

-

Análise de Pareto;

-

Diagrama de causa-efeito;

-

Histograma

-

Folhas de controle;

-

Diagramas de correlação;

-

Gráficos de controle;

-

Fluxogramas (fala-se que a sétima ferramenta poderia ser também a estratificação de dados, ou o "diagrama de concentração de defeitos").

2.7. GENICHI TAGUCHI

Japonês nascido em 1924, Taguchi contribuiu para o estudo da qualidade principalmente através do conceito de função perda da qualidade.

Em essência, isto quer dizer que, conforme as características de qualidade se afastam do valor esperado (valor-alvo), há uma perda para a sociedade, mesmo que o valor se encontre dentro dos limites de especificação. Então, se uma peça deve ter 5 mm e a especificação estabelece que até o limite de + ou - 1 mm ela é aceitável, ela pode ter entre 4 e 6 mm e ser aceitável. Apesar disso, para Taguchi, ela deve ter exatamente 5 mm, pois qualquer diferença em relação ao valor-alvo significa perda de qualidade.

Este conceito traz em si a ideia de que a redução das perdas e dos custos não está ligada diretamente à questão da conformidade às especificações, mas sim à redução da variabilidade dos produtos em torno do valor-alvo pretendido.

- Vamos agora estudar alguns tópicos adicionais sobre qualidade para que o assunto da aula fique ainda mais completo.

3. DO TQC AO TQM

A evolução do conceito de qualidade até o desenvolvimento dos modelos de excelência gerencial tem os seus passos iniciais com o desenvolvimento dos modelos de controle de qualidade.

É fundamental que se retome uma discussão sobre o que significa Controle da Qualidade Total (TQC). Neste sentido, uma definição-padrão é aquela apresentada por uma das normas da série ISO 9000, para qual, a gestão da qualidade é o conjunto de atividades coordenadas para dirigir e controlar uma organização com relação à qualidade, englobando o planejamento, o controle, a garantia e a melhoria da qualidade, sendo uma espécie de consenso internacional a respeito das boas práticas de administração da qualidade.

É possível dizer ainda que essa série de normas é uma síntese de normas anteriores que regulamentava a relação entre fornecedores e compradores, possibilitando a auditoria de qualidade com base em um padrão de excelência.

Apesar dessa definição-padrão para efeito da referida norma, não existe uma única forma de ver o controle de qualidade, como podemos perceber através das visões de Feigenbaum e lshikawa:

-

Para Feigenbaum, que representa a visão americana, TQC poderia ser definido como um sistema efetivo para integrar os esforços de desenvolvimento, manutenção e melhoramento da qualidade dos vários grupos em uma organização, de modo a possibilitar produção e prestação de serviços no nível mais econômico possível, o que permitiria a completa satisfação do consumidor. Ele valoriza o papel do departamento de controle da qualidade, apesar de reconhecer a importância de todos da organização, na elaboração da qualidade.

-

Para lshikawa, que representa a visão japonesa, o TQC seria chamado de controle de qualidade por toda a empresa (Company Wide Qua/ity Control - CWQC). Destaca-se a importância do gerenciamento por diretrizes (também chamado de Hoshin Kanri), que consiste em desdobrar as diretrizes centrais da organização em diretrizes para os funcionários e implementá-las através do uso do ciclo PDCA, envolvendo os funcionários nesse processo.

Partindo das visões de controle de qualidade, surge uma visão mais aplicada à gestão da qualidade pela organização, que dá maior importância à participação dos funcionários, como no modelo Japonês de CWQC: a Gestão da Qualidade Total (Total Quality Management - TQM). Para as normas ISO brasileiras, a qualidade total representa o "modo de gestão de uma organização, centrado na qualidade, baseado na participação de todos os seus membros, visando ao sucesso no longo prazo, por meio da satisfação do cliente e dos benefícios para todos os membros da organização e sociedade".

Não se trata de uma mera reinvenção da qualidade. Na verdade, para o TQM, a qualidade é papel de todos, e não apenas de um departamento centralizado de qualidade.

Apesar da existência dessa e de outras definições, lembro que está estudando para um concurso público! Tenha em mente que não há uma definição universal e única para TQM!

Na verdade, o TQM é uma evolução do TQC/CWQC, englobando aspectos como a relação com fornecedores e considerando que todos os funcionários devem estar R

Mais do que isso, o TQM estabelece que a melhoria contínua deve ser empregada para que a organização possa sempre se desenvolver mais, partindo do princípio de que não há uma situação que seja boa o suficiente para se dizer que não é possível melhorar mais.

Para entendermos bem essa evolução, precisamos entender o que significa melhoria contínua.

3.1 MELHORIA CONTÍNUA

Em sua essência, a melhoria continua é uma técnica de mudança organizacional que acontece de forma incremental, participativa, suave e contínua, atuando no nível operacional e funcionando de baixo para cima na organização.

Ela é baseada nos círculos de controle de qualidade (CCQ), que são grupos de 6 a 12 pessoas voluntárias que se reúnem semanalmente para discutir e resolver problemas sobre as atividades do trabalho da organização. A ideia chave é que as pessoas que executam os trabalhos conhecem a organização melhor do que ninguém e podem propor melhorias importantes.

Assim como nos CCQs, a melhoria contínua é centrada nas pessoas e visa uma qualidade contínua dos produtos e serviços da organização, sob uma perspectiva de longo prazo.

A filosofia da melhoria contínua deriva do Kaizen, que significa "mudanças positivas" para a organização (do japonês). O Kaizen é uma filosofia que busca fazer com que as coisas sejam feitas de maneira cada vez melhor por todos os empregados da organização, através de melhorias levantadas e implementadas pelos próprios funcionários.

Além disso, o Kaizen busca também o atingimento de resultados específicos como a eliminação de desperdícios de qualquer natureza e a elevação da qualidade em suas vár ias dimensões.

Chiavenato (2011) destaca que, na realidade, o Kaizen é uma forma de pensar e agir baseada nos seguintes princípios:

-

Promover aprimoramentos contínuos.

-

Enfatizar os clientes.

-

Reconhecer os problemas abertamente.

-

Promover a discussão aberta e franca.

-

Criar e incentivar equipes multifuncionais.

-

por meio de equipes multifuncionais.

-

Incentivar o relacionamento entre as pessoas.

-

Desenvolver a autodisciplina.

-

todas as pessoas.

-

e capacitar todas as pessoas.

O Kaizen é uma filosofia de melhoria contínua que serve para a vida como um todo. Aplicado à organização, aponta para que os empregados estejam realizando suas tarefas de uma maneira melhor a cada dia, reduzindo desperdícios, melhorando a qualidade, melhorando relacionamentos interpessoais etc. Tudo isso com foco no cliente, comunicação aberta, disciplina e comunicação...

Vamos agora ao estudo da qualidade total.

3.2. O GERENCIAMENTO DA QUALIDADE TOTAL (TQM)

A qualidade total surge como consequência da aplicação da melhoria contínua nas organizações, tendo em conta as necessidades dos clientes e a qualidade em toda a cadeia de fornecimento. Em sua essência, trata-se de um programa de melhoria contínua que engloba toda a organização em todos os seus aspectos, incluindo desde o nível operacional e administrativo até a cúpula estratégica da organização, tendo como foco o impacto estratégico da gestão da qualidade (assim, é fundamental que haja um planejamento estratégico da qualidade). Como o TQM possibilita que todos os funcionários tomem decisões em sua área de trabalho, é possível associá-lo à moderna técnica do empoderamento de pessoas (empowerment).

Sendo abordagens incrementalistas baseadas uma na outra, tanto a melhoria contínua quanto a qualidade total seguem o seguinte processo:

-

Escolha de uma área de melhoria: é aqui que serão definidas as áreas que passarão pelo processo de melhoria. Definição da equipe de trabalho que tratará da melhoria: é uma etapa importante, dado que a ênfase desses processos está na melhoria baseada nas equipes.

-

Definição da equipe de trabalho que tratará da melhoria: é uma etapa importante, dado que a ênfase desses processos está na melhoria baseada nas equipes.

-

Identificação de benchmarks: benchmarks são padrões de comparação e excelência que a organização pode utilizar como referência para os seus próprios processos. Eles podem ser internos (quando se utiliza um processo da mesma organização como referência) ou externos (quando o processo-referência está fora da organização).

-

Análise do método atual: é nessa etapa que a equipe de trabalho analisa os métodos utilizados na área a ser melhorada e identifica como eles podem ser melhorados para alcançar ou superar o benchmark estabelecido.

-

Estudo piloto da melhoria: aqui a equipe desenvolve um estudo piloto sobre a proposta de melhoria e testa sua relação custo x benefício para verificar se ele deve ser implementado;

-

Implementação da melhoria: é nessa etapa que a equipe de trabalho propõe a melhoria a ser implementada e a Direção da organização assegura sua implementação, fortalecendo a competitividade da organização e aumentando a motivação das pessoas que trabalham no processo de melhoria.

-O ciclo Acabou?

- Resposta: NÃO! Na verdade, por ser um processo contínuo, ao atingir essa última etapa, o processo recomeça, voltando para uma nova escolha de área para melhoria!

Deve-se destacar ainda que a qualidade total é um conceito que está baseado nos grupos de trabalho e considera a necessidade de empoderamento (empowerment) das pessoas para que elas possam realmente decidir quais como melhorar as diversas questões organizacionais. Com isso, têm-se a delegação de competências, a tolerância aos erros, e a disseminação de informações para todos os interessados na organização.

Buscando entender os vários conceitos que fazem parte da qualidade total, Miguel (2005) fez um apanhado dos vários elementos do TQM, segundo diferentes autores. Com base em sua visão, apresento a seguir uma relação desses elementos:

Com base no TQM é que foram desenvolvidos os programas de excelência gerencial para as organizações.

- Vamos entender as bases dessa evolução no próximo tópico.

3.3. DO TQM AOS MODELOS DE EXCELÊNCIA GERENCIAL

Para que houvesse uma nova evolução do TQM rumo a modelos de excelência gerencial foi necessário que os interesses de todos os stakeholders da organização, não apenas os dos acionistas, fossem considerados.

Stakeholders são as pessoas e grupos de pessoas que detém algum tipo de interesse na organização. Esse conceito inclui:

-

Acionistas/Proprietários;

-

Trabalhadores;

-

Fornecedores;

-

Sociedade de forma ampla (inclusive clientes);

-

Comunidade local onde a empresa atual.

Considerando que as organizações não servem apenas aos seus acionistas, mas também a todos os outros stakeholders, é que são desenvolvidos os modelos de excelência gerencial.

Eles consistem em modelos que devem servir de orientação básica para que as organizações atinjam a excelência organizacional, ou seja, para que sua gestão seja feita da maneira certa na primeira vez, tendo em conta critérios previamente estabelecidos.

Esses modelos geram competições por prêmios de qualidade. Nesse sentido, as organizações que buscam a promoção de modelos de excelência se inscrevem para concorrer a esses prêmios, de modo a possibilitar uma avaliação externa e imparcial que pode gerar reconhecimento oficial pela qualidade de suas práticas.

Uma vez inscritas para concorrer aos prêmios, as organizações participantes (públicas/privadas, indústria/serviço/comércio, etc.) preenchem relatórios de gestão padronizados, para que os vários critérios possam ser avaliados através de pontuação atribuída a critérios e itens pré-determinados.

Independentemente de receber as premiações, as organizações participantes recebem um relatório da avaliação de suas práticas internas, para que possam utilizá-lo como insumo para o seu melhoramento e a busca de excelência.

Vamos agora ao estudo do modelo de excelência da FNQ.

4. O MODELO DA FUNDAÇÃO NACIONAL DA QUALIDADE (FNQ)

Este é um modelo de excelência em gestão de natureza não-prescritiva, que considera vários aspectos da gestão organizacional para distribuir prêmios às organizações. O modelo levanta questionamentos, permitindo um exercício de reflexão sobre a gestão e a adequação de suas práticas aos conceitos de uma empresa de classe mundial.

Vamos abordar aqui os pontos mais importantes sobre o modelo, sempre partindo dos pontos destacados pela própria FNQ, que são os mais prováveis de ser cobrados no seu concurso público.

O modelo da FNQ é inspirado nos modelos norte-americano, europeu e japonês, incluindo ainda conceitos próprios ao contexto brasileiro. Segundo a FNQ, os fundamentos da excelência (Modelo 2016) são os seguintes:

-

Pensamento sistêmico: compreensão e tratamento das relações de interdependência e seus efeitos entre os diversos componentes que formam a organização, bem como entre estes e o ambiente com o qual interagem.

-

Aprendizado organizacional e inovação: busca e alcance de novos patamares de competência para a organização e sua força de trabalho, por meio da percepção, reflexão, avaliação e compartilhamento de conhecimentos, promovendo um ambiente favorável à criatividade, experimentação e implementação de novas ideias capazes de gerar ganhos sustentáveis para as partes interessadas.

-

Liderança transformadora: atuação dos líderes de forma ética, inspiradora, exemplar e comprometida com a excelência, compreendendo os cenários e tendências prováveis do ambiente e dos possíveis e feitos sobre a organização e suas partes interessadas, no curto e longo prazos; mobilizando as pessoas em torno de valores, princípios e objetivos da organização; explorando as potencialidades das culturas presentes; preparando líderes e pessoas; e interagindo com as partes interessadas.

-

Compromisso com as partes interessadas: estabelecimento de pactos com as partes interessadas e suas inter-relações com as estratégias e processos, numa perspectiva de curto e longo prazos.

-

Adaptabilidade: flexibilidade e capacidade de mudança em tempo hábil, frente a novas demandas das partes interessadas e alterações no contexto.

-

Desenvolvimento sustentável: compromisso da organização em responder pelos impactos de suas decisões e atividades, na sociedade e no meio ambiente, e de contribuir para a melhoria das condições de vida, tanto atuais quanto para as gerações futuras, por meio de um comportamento ético e transparente.

-

Orientação por processos: reconhecimento de que a organização é um conjunto de processos, que precisam ser entendidos de ponta a ponta e considerados na definição das estruturas: organizacional, de trabalho e de gestão. Os processos devem ser gerenciados visando à busca da eficiência e da eficácia nas atividades, de forma a agregar valor para a organização e as partes interessadas.

-

Geração de valor: alcance de resultados econômicos, sociais e ambientais, bem como de resultados dos processos que os potencializam , em níveis de excelência e que atendam às necessidades e expectativas das partes interessadas.

O Modelo considera ainda a aplicação do ciclo de aprendizagem para melhoria contínua, o chamado PDCL: Planejamento (P), Execução (D), Verificação (C) e aprendizado (L). Este ciclo pode ser aplicado em âmbito global da organização, de maneira sistêmica, mas também é aplicável diretamente aos processos operacionais.

Com base nisso, foi criada a nova figura que representa o MEG da FNQ:

Importante destacar que a própria FNQ estabelece que a organização deve adaptar o MEG (remontá-lo) na melhor forma que defina o seu modelo de gestão - por isso, trata-se de modelo adaptável à organização e ao seu ambiente. Importante destacar a existência de adaptação do modelo para a gestão pública, com conteúdos específicos para cada critério.

Ele foi desenvolvido pela Fundação Nacional da Qualidade (FNQ) como uma forma de incentivar a competitividade das empresas situadas no Brasil. A FNQ, entidade privada sem fins lucrativos, constituída pela união de grandes empresas atuantes no Brasil, entrega o prêmio anualmente às empresas vencedoras.

Segundo a FNQ, os principais benefícios da adoção do modelo por organizações incluem:

-

Promove a competitividade e a sustentabilidade.

-

Proporciona um referencial para a gestão de organizações.

-

Promove o aprendizado organizacional.

-

Possibilita a avaliação e a melhoria da gestão de forma abrangente.

-

Prepara a organização para participar do Prêmio Nacional da Qualidade® {PNQ).

-

Melhora a compreensão de anseios das partes interessadas.

-

Mensura os resultados do negócio de forma objetiva.

-

Desenvolve a visão sistêmica dos executivos.

-

Estimula o comprometimento e a cooperação entre as pessoas.

-

Incorpora a cultura da excelência.

-

Uniformiza a linguagem e melhora a comunicação gerencial.

-

Permite um diagnóstico objetivo e a mensuração do grau de maturidade da gestão.

-

Enfatiza a integração e o alinhamento sistêmico.

Além do Modelo de Excelência em Gestão (MEG), a FNQ possui também um Prêmio Nacional de Qualidade (PNQ), que é voltado para reconhecimento das organizações com grau de excelência em qualidade, com base no MEG.

Segundo a própria FNQ, as principais mudanças no Prêmio 2017 em relação ao modelo até então vigente foram:

(...)

Em substituição ao atual Relato Organizacional, a inscrição/candidatura da organização será feita de modo digital, por meio do preenchimento de uma autoavaliação, com base no Modelo de Excelência da Gestão® (MEG) - 21a edição, que será disponibilizada no portal da FNQ.

Ao optar por participar do processo de reconhecimento, a organização deverá fazer o upload de documentos obrigatórios, que serão solicitados no momento do preenchimento.

A avaliação será feita por meio de um Instrumento de Avaliação {IA}, que será disponibilizado em nosso portal no primeiro trimestre de 2017.

As visitas continuarão a serem feitas, contudo, em formato mais condensado. "A etapa de visitação por uma equipe reduzida de avaliadores às organizações candidatas acontecerá em até três dias, otimizando o tempo de todos os envolvidos e diminuindo o valor dispendido pelas organizações nesse processo", afirma Bardagi.

Outro ponto importante é a mudança do calendário do reconhecimento , que levou em consideração a adaptação das organizações interessadas diante do novo processo e do novo MEG.

Desta forma, as inscrições/candidaturas devem ocorrer no período de julho a agosto de 2017, com visita às organizações entre outubro e novembro. A solenidade de reconhecimento acontecerá no primeiro trimestre de 2018.

O reconhecimento em si também sofrerá alteração. Todas as organizações que superarem uma pontuação mínima (a ser definida) serão elencadas em uma lista, com as melhores empresas em gestão do País, a ser divulgada pela FNQ.

Assim como em 2016, não haverá custos com o evento de reconhecimento para as organizações selecionadas para esta lista.

(...)

Recomendo, por fim, que veja as informações oficiais da FNQ sobre seu modelo de autoavaliação: http://www.fng.org.br/aprenda/metodologia-meg/modelo-de-excelencia-da-gestao.

5. FERRAMENTAS DE GESTÃO DA QUALIDADE

São várias as ferramentas de gestão da qualidade. A ideia é trazer as mais mencionadas pela literatura , para que a sua capacitação seja a melhor possível.

Vamos então estudar as diferentes ferramentas da qualidade!

5.1. LISTAS DE VERIFICAÇÃO

Esta ferramenta, também chamada de folha (ou lista) de controle, ou ainda de folha de coleta de dados, é um método simples e prático para que se possa verificar o cumprimento de requisitos ou monitorá-los em um processo.

Elas podem ser de dois tipos: as listas simples e as listas de frequência.

As listas simples são as famosas check/ists , através das quais é possível conferir os itens pré determinados. É possível dizer que a lista de compras que algumas pessoas elaboram antes de ir ao supermercado são listas de verificação que devem ser marcadas com um "OK" a cada produto da lista que é colocado no carrinho.

Nas organizações, a lista de verificação simples assegura a qualidade ao garantir que todos os procedimentos previstos sejam executados em um determinado processo, por exemplo.

A lista de verificação de frequência, por sua vez, é aquela na qual são levantados os dados para que se saiba quantas vezes cada um dos eventos esperados acontece ao longo do tempo.

Esse levantamento de frequência se torna mais fácil com a referida lista, uma vez que basta realizar marcações ao longo de cada um dos eventos pré-determinados para que se levante a sua frequência.

Um exemplo deste último tipo é apresentado a seguir:

Este levantamento pode servir de base para a elaboração de um histograma sobre o que está sendo analisado, de modo que os dados sejam visualizados de maneira mais intuit iva, como será visto a seguir.

5.2. ESTRATIFICAÇÃO

Consiste em separar os dados em categorias (estratos) para posterior interpretação de maneira mais analítica com o uso de outras ferramentas, como o histograma, por exemplo.

5.3. HISTOGRAMA

O histograma é uma ferramenta muito útil para que se possa visualizar a distribuição de frequências de qualquer evento. Ele normalmente aparece como um gráfico de barras, que representam a frequência de cada um dos eventos analisados, com base em uma tabela de levantamento dos dados.

Através da observação da forma do histograma, é possível verificar inadequações no processo analisado. O levantamento de histogramas ao longo do tempo permite a comparação entre o comportamento de uma variável em diferentes momentos no tempo.

- Vamos imaginar uma aplicação prática:

- Imagine que um call-center deseje melhorar a qualidade do seu atendimento através da redução do tempo de espera dos usuários para, no máximo, 2 minutos e meio. Neste caso, a primeira coisa a se fazer é um levantamento dos dados do atendimento para a construção de um histograma que possibilite visualizar o tempo de atendimento por cliente, conforme a seguir:

Com base neste histograma, percebe-se que a maior parte dos clientes já está esperando no máximo 2,5 minutos. Na verdade, a maior parte está esperando entre 1,5 e 2,5 minutos.

Para resolve r o problema de qualidade da empresa, seria necessário tomar atitudes para que não haja demoras acima do limite desejado.

Neste sentido, as medidas tom adas devem fazer com que o gráfico se desloque para a esquerda, para que não haja qualquer cliente com tempo de espera maior do que 2,5 minutos.

Com base no histograma, é possível a realização da análise de Pareto, que você verá no próximo tópico.

5.4. ANÁLISE DE PARETO

A análise de Pareto, ou Diagrama de Pareto, é uma técnica que busca priorizar determinados fatores. Foi criado pelo economista Vilfredo Pareto, com a observação de que 80% da renda se encontrava nas mãos de 20% da população.

Enquanto ferramenta de qualidade, ela permite que se verifiquem quais os produtos/serviços mais demandados por um setor ou quais as causas prioritárias a serem resolvidas para evitar problemas de qualidade.

De modo geral, esta técnica parte do princípio de que poucas causas geram a maior parte dos problemas, são as causas chamadas de vital few (estranhamento traduzido para português como "pouco vitais"). Assim, ela é conhecida também como princípio 80 / 20 (80% dos problemas são explicados por 20% das causas) sendo a base para análises de prioridades como a curva ABC de compras. Na prática, esses percentuais não são exatos (80% / 20%). É possível que a banca fale em 70/30 ou 90/10 - você deve aceitar se isso acontecer. A ideia geral é a de que grande parte das consequências são causadas por uma pequena parte das causas.

Em oposição aos elementos "pouco vitais" (20% dos elementos que explicam 80% das consequências/ problemas), haveria ainda a identificação dos elementos "muito triviais" (trivial many). Note que o foco é a identificação dos "pouco vitais", os "muito triviais" são apenas consequência!

Para construção do Diagrama de Pareto, os dados da tabela que servem de referência devem ser colocados em ordem decrescente, de modo que a o gráfico possa ser construído do item com maior frequência para o que possua menor frequência, somando-se ainda as frequências percentuais acumuladas para apresentação no diagrama.

Um exemplo de uso do diagrama de Pareto é o seguinte:

Observe que, no exemplo dado, apenas duas causas (20% das causas), representam 80% do total dos problemas (consequências) observados na produção.

Com base neste gráfico, o gestor pode decidir que, para melhorar a qualidade (e diminuir as não conformidades) os principais defeitos a serem resolvidos seriam: parafuso solto e sujeira. Ações para resolver estes dois problemas resolveriam 80% dos problemas da produção!

Deste modo, fica claro que o diagrama de Pareto busca auxiliar o tomador de decisões através da priorização de quais causas devem ser atacadas com maior intensidade e rapidez para a melhoria da qualidade.

(CESPE/FUB/Administrador) Caso deseje identificar as subcategorias com maiores índices de insatisfação para, posteriormente, priorizar suas ações corretivas apenas nas subcategorias mais relevantes, a instituição deverá utilizar o diagrama, ou método de análise, de Pareto.

Comentário:

O diagrama de Pareto é uma ferramenta apropriada para realizar a priorização, conforme mencionado pela questão!

GABARITO: Certo

5.5. DIAGRAMA DE CAUSA-EFEITO (ISHIKAWA)

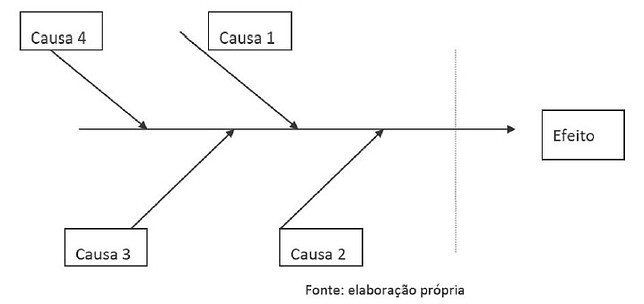

O diagrama de lshikawa, também conhecido como Gráfico Espinha de Peixe (fisfhbone), diagrama de causa e efeito, método 4M ou 6M, é uma ferramenta muito útil para que se possam visualizar as várias causas que levam a um efeito, de maneira hierárquica, em função dos grupos de causas estabelecidos previamente ou observados durante o processo de classificação.

Um diagrama deste tipo é estruturado da seguinte forma:

Para cada efeito podem existir diversas causas dentro de várias cat egorias , como método, mão de obra, matéria-prima, máquinas (4Ms), mensuração e meio ambiente (6 Ms).

Com isso, é possível ampliar a visão das possíveis causas de um problema para que se possa pensar sobre sua resolução. A fácil visualização é uma de suas grandes vantagens, pois as causas e subcausas são estruturadas de modo a formar um gráfico parecido com uma espinha de peixe.

Um exemplo de diagrama deste tipo é apresentado pelo SEBRAE:

(CESPE/FUB/Administrador) Uma instituição de ensino superior pesquisou, entre seus alunos, o grau de satisfação nas seguintes categorias, divididas em subcategorias: qualidade do ensino, das instalações, do atendimento administrativo e do projeto pedagógico. Devido ao alto grau de insatisfação apresentado nos resultados de várias categorias, a instituição resolveu investir na melhoria do índice de satisfação, por meio de ações de gestão da qualidade.

Com relação a essa situação hipotética, julgue o item a seguir:

(CESPE/FUB/Administrador) A ferramenta a ser utilizada para diagnosticaras causas: de insatisfação das diversas categorias pesquisadas é o diagrama de lshikawa, também conhecido como diagrama Espinha de Peixe.

Comentário:

Em outras palavras, a ferramenta de lshikawa é aquela que ajuda a identificar causas para os efeitos (baixo grau de satisfação em cada categoria). É exatamente isso!

GABARITO: Certo.

5.6. DIAGRAMA DE DISPERSÃO

Trata-se de uma ferramenta que ajuda a identificar visualmente a existência de uma cor relação entre duas variáveis. A correlação estará presente através de uma relação linear, seja positiva ou negativa.

Esta ferramenta possibilita também a verificação de quais os fatores que se relacionam com determinado problema do processo, considerando-se cada problema uma variável distinta.

Cada uma das variáveis ficará representada em um dos eixos do gráfico ("X" ou "Y") e os pontos correspondentes às mesmas serão marcados. Quanto mais reta e inclinada (próximo a 45º) for a distribuição dos pontos no gráfico maior será a relação identificável, podendo ser positiva (quando as duas variáveis crescem juntas) ou negativa (quando uma variável cresce enquanto outra diminui). Uma distribuição que se assemelhe a uma reta horizontal ou vertical estará demonstrando uma relação nula (ou inexistência de relação} entre as variáveis estudadas.

Apresento, a seguir, um exemplo de diagrama de dispersão que correlaciona a ocorrência de falhas em determinado processo com a inoperância do sistema de informação:

O que se percebe no gráfico apresentado é que, quanto maior o número de ocorrências de inoperância do sistema de informação, maior também será a ocorrência de falhas no processo, demonstrando uma clara associação das variáveis.

Esta associação pode induzir você a pensar que uma variável é a causa, e outra é a consequência, o que está errado! O gráfico apenas mostra a associação. É possível que uma seja consequência da outra, mas isso não é uma certeza. É possível também que outra variável interveniente esteja atuando "escondida", sendo a responsável pela associação.

No caso do gráfico apresentado, uma terceira variável "escondida" poderia ser a variável "quedas de energia". Imagine que as quedas de energia podem gerar, ao mesmo tempo, ocorrência de falhas no processo e de inoperância no sistema de informação. Assim, a causa das falhas de processo poderia ser a falta de energia, e não a inoperância do SI.

5.7. GRÁFICOS (CARTA) DE CONTROLE/CARTA DE TENDÊNCIA

Os gráficos de controle são utilizados para representar graficamente a variação de um processo, o que possibilit a o seu monitoramento ao longo do tempo em relação ao que é esperado.

Ele permite ao analista a investigação dos problemas ocorridos no momento em que os "descontroles" do processo foram identificados, sendo úteis ainda para monitorar os resultados das ações corretivas implementadas.

Visualmente, trata-se de um gráfico de linha acompanhado pela linha superior, inferior e "média" dos valores esperados para a variável do processo monitorada.

Existem diferentes formas de observar o eventual descontrole do processo. De forma mais geral, pode-se considerar que o processo estará fora de controle quando:

-

Um ou mais pontos estão fora dos limites de controle.

-

Muitos pontos consecutivos se encontram do mesmo lado da linha central (acima ou abaixo);

-

Aparece uma tendência clara descendente ou ascendente;

-

Há um padrão de dados incomum ou não aleatório;

-

Há um padrão de pontos repetidos acima e abaixo da linha;

-

Vários pontos se encontram muito próximos aos limites de controle.

5.8. FLUXOGRAMAS

Esta é uma ferramenta muito utilizada para que se possa visualizar com facilidade o fluxo de ações para que determinada tarefa possa ser executada.

Trata-se de um gráfico que representa o fluxo ou sequencia normal de qualquer trabalho, produto, documento, informação, etc., utilizando-se de diferentes símbolos que esclarecem o que está acontecendo em cada etapa.

Segundo Cury (2012), os fluxogramas possuem as seguintes vantagens:

-

Permitir verificar como funcionam, realmente, todos os componentes de um sistema, mecanizado ou não, facilitando a análise de sua eficácia;

-

Entendimento mais simples e objetivo do que o de outros métodos descritivos;

-

Facilitar a localização das deficiências, pela fácil visualização dos passos, transportes, operações, formulários, etc.;

-

Aplicação a qualquer sistema , desde o mais simples aos maias complexos;

-

O rápido entendimento de qualquer alteração que se proponha nos sistemas existentes, por mostrar claramente as modificações introduzidas.

Os fluxogramas podem ser de diferentes tipos:

-

Fluxograma vertical: é aquele construído com base em formulários padronizados para processos dentro de uma mesma área da organização. É mais apropriado a processos mais simples e que não transitam entre diferentes órgãos.

-

Fluxograma administrativo: se utiliza dos mesmos símbolos do fluxograma vertical, mas pode ser elaborado de forma mais livre, sem a necessidade do uso do formulário padronizado;

-

Fluxograma global (de colunas): é o fluxograma que possibilita a visualização de como o fluxo de trabalho passa de um órgão para outro, já que estes ficam dispostos na mesma folha, em colunas, sendo mais apropriado aos fluxos mais complexos e que envolvem diferentes órgãos.

Como cada fluxograma é diferente, é fundamental que se defina a técnica a ser utilizada antes de começar o trabalho de elaboração do fluxograma, uma vez que cada uma das técnicas poderá exigir o levantamento de informações diferentes, pois diferentes atividades e símbolos são retratados em cada tipo de fluxo.

Neste sentido, não há padronização 100% aceita quanto aos símbolos utilizados no fluxograma. Para Cury (2012) os símbolos básicos para o fluxograma vertical e o administrativo são:

Chinelato Filho (2008) destaca os seguintes símbolos como sendo bastante importantes para os fluxogramas:

Exemplos de fluxogramas são apresentados a seguir para que você possa entendê-los melhor.

Exemplo de fluxograma vertical (CURY, 2012):

Exemplo de fluxograma administrativo (CURY, 2012):

Exemplo de fluxograma global (Chinelato Filho, 2008)

(CESPE/MPOG/ATA) Tendo em vista que há diversos tipos de fluxogramas passíveis de utilização nas organizações, o gerente deve escolher o modelo de fluxograma que melhor se adapte à sua forma de conduzir e que, também, seja mais adequado ao processo em estudo.

Comentário:

Questão puramente interpretativa. O gerente, de fato, deve escolher a melhor técnica de fluxograma a partir de sua necessidade e do processo desenhado.

GABARITO: Certo.

5.9. BENCHMARKING

Benchmarking é um processo sistemático e contínuo de avaliação dos produtos, serviços e processos de trabalho das organizações/departamentos/etc. que são reconhecidas como representantes das melhores práticas, com a finalidade de comparar desempenhos e identificar oportunidades de melhoria na organização que está realizando o benchmarking.

Em outras palavras, é um processo de comparação conduzido por uma organização ou área em relação a outra que seja tida como referência.

O benchmarking deve ser percebido como algo sistemático, que envolve toda a organização, e não isolado. Ele é também um processo gerencial, à medida que ele serve para que os tomadores de decisão na empresa guiem o seu pensamento.

Os principais tipos de benchmarking são:

Este tipo de benchmarking é baseado numa função específica, servindo para trocar informações acerca de uma atividade bem definida como, por exemplo, a distribuição, o faturamento ou embalagem. Alguns autores vinculam o conceito de benchmarking funcional ao de benchmarking genérico, pela possibilidade de os mesmos serem utilizados sem se levar em consideração a concorrência direta da organização que aprende ou patrocina o estudo e a organização "investigada".

1. Benchmarking Competitivo

Caracteriza-se por ter como alvo específico as práticas dos concorrentes. Na prática, é o menos usual, uma vez que é quase impossível que as empresas facilitem o acesso a dados que estão ligados diretamente com a sua atividade à concorrência. Por isto, muitas vezes, é necessário contratar uma consultora externa para obter informações para a realização do benchmarking competitivo.

Neste tipo de benchmarking, produtos, serviços ou processos da organização são comparados com os de organizações concorrentes, buscando superá-los.

2. Benchmarking interno

Neste tipo de benchmarking, a procura pelas melhores práticas ocorre dentro da própria organização, em diferentes unidades (outros departamentos, sedes, etc.). Neste caso, há uma maior facilidade na obtenção de parcerias para realização do benchmarking. Além disso, apresenta custos mais baixos e a valorização das melhores práticas internas à organização.

A grande desvantagem é que as práticas organizacionais objeto de comparação estarão sempre impregnadas com os mesmos paradigmas.

Em resumo, são comparados valores ou processos entre unidades internas da organização, com vista a disseminar as melhores práticas por todas as unidades. Por suas vantagens, esse tipo de benchmarking é bastante utilizado.

3. Benchmarking genérico

É neste tipo de Benchmarking que encontramos a maioria dos exemplos práticos e onde as empresas estão mais dispostas a colaborar e a ser mais verdadeiras na disponibilização dos padrões, ou "benchmarks".

Ele é não competitivo, pois são comparados processos entre organizações com a colaboração do "benchmark partner" , que poderá ter vantagens diversas em permitir que sejam dissecados os seus processos. Essas vantagens incluem notoriedade, prestígio, volume de negócios, etc. Ocorre quando o Benchmarking é baseado num processo que atravessa várias funções da organização e pode ser encontrado na maioria das empresas do mesmo porte, como por exemplo, o processo desde a entrada de um pedido até a entrega do produto ao cliente.

4. Benchmarking funcional

Neste sentido, são comparados processos similares entre organizações, independentemente do setor de atividade (comparação entre empresas não concorrentes).

(CESPE/MPOG/Técnico de Nível Superir) Não se recomenda a utilização de benchmarking para a identificação de possíveis melhorias em um processo devido às especificidades de cada negócio.

Comentário:

Ao contrário: como o propósito é identificar possíveis melhor ias, é possível utilizar o benchmarking para comparar as práticas da organização com as melhores práticas utilizadas!

GABARITO: Errado.

5.10. "5W2H" / PLANO DE AÇÃO

O 5W2H, também conhecido como plano de ação, é uma ferramenta de qualidade muito utilizada no planejamento operacional de processos, planos e procedimentos. O objetivo é levantar vários questionamentos que servem como base para a completa definição das ações a serem tomadas.

Neste sentido, as perguntas a serem resolvidas sobre o problema que está sendo investigado ou sobre o processo a ser planejado são:

-

What - O que deve ser executado?

-

Who - Quem irá executar a tarefa?

-

Where - Onde será executada a ação?

-

When - Quando será executada a ação?

-

Why - Por que será executada a tarefa?

-

How - Como será executada a tarefa?

-

How much - Quanto custa para executar a ação?

5.11. MATRIZ GUT

A Matriz GUT é uma ferramenta criada por dois estudiosos (Kepner e Tregoe) com o objetivo de estabelecer a prioridade de fatores, onde a sigla GUT significa Gravidade x Urgência x Tendência.

Por definir as prioridades, esta é uma ferramenta bastante útil para a tomada de decisões nas organizações.

Na análise ambiental, essa ferramenta é importante à medida que possibilita, com as devidas adaptações, o estabelecimento da predominância interna de pontos fortes e fracos e a predominância externa em termos de oportunidades e ameaças. Vamos ver o que significa cada um dos aspectos analisados:

-

Gravidade: representa o impacto do fator sobre a organização. É o que afeta em profundidade a essência, objetivo ou resultado da organização ou pessoa. A avaliação da gravidade deve ser feita tendo como base o prejuízo que pode advir da situação.

-

Urgência: representa uma dimensão relativa ao prazo que existe para tomada de decisão/implementação de ações. É resultado da pressão do tempo sobre a situação provocada sobre o fator avaliado.

-

Tendência: representa o potencial de desenvolvimento da situação caso não lhe seja dada a atenção necessária.

Para cada um dos aspectos analisados deve ser estabelecida uma nota, conforme tabelas abaixo, adaptadas de Djalma de Oliveira (2012):

Após o estabelecimento de notas para diferentes fatores, multiplicam-se as notas com o objetivo de obter a pontuação de cada fator e ordená-los em ordem de prioridade, conforme exemplo a seguir:

Com isto, percebe-se a facilidade do uso da matriz GUT para priorizar fatores.

(CESPE/TCU/Auditor Federal de Controle Externo - Tl) Se comparada à matriz SWOT, a matriz GUT apresenta maior aplicabilidade ao planejamento estratégico por considerar os fatores gravidade, urgência e tendência no apoio à análise e na gestão de problemas e, consequentemente, possibilitar mais riqueza no suporte à produção de cenários de curto, médio e longo prazos.

Comentário:

A questão misturou matriz GUT com a Matriz SWOT do planejamento estratégico. Sabemos ! que a matriz GUT serve para priorização. A matriz SWOT, por sua vez, realiza uma análise ! ambiental para o diagnóstico - importante etapa do planejamento estratégico - analisando forças, fraquezas, oportunidades e ameaças.

As duas matrizes não têm nada a ver uma com a outra. Cada uma serve para um propósito distinto, por isso não é possível falar que uma é melhor ou mais aplicável que a outra!

GABARITO: Errado.

5.12. BRAINSTORMING

O brainstorming é uma técnica de auxílio à tomada de decisão e à solução de problemas, sendo utilizada também como ferramenta de qualidade, à medida que possibilita um amplo levantamento de ideias sobre determinado tema.

Podendo ser traduzida como tempestade cerebral, esta técnica consiste na reunião de grupos de pessoas que expõem seu pensamento livremente, de modo a incentivar o surgimento de novas ideias.

Os seus princípios básicos são os seguintes (Chinelato Filho, 2008):

-

Inexistência de críticas - ninguém pode ser depreciado pelo que sugeriu.

-

Incentivo à ideia absurda - tal ideia pode trazer a chave da originalidade; por meio da analogia, pode se chegar à grande solução.

-

Estímulo à quantidade - a quantidade acaba por gerar qualidade.

-

Os melhoramentos e analogias - combinando-se elementos, dando-se uma feição lógica e real às "ideias absurdas" chega-se a grandes descobertas. O produto final de brainstorming é um elenco de ideias ordenado.

Este mesmo autor apresenta um roteiro a ser utilizado como sequência básica para uma sessão de brainstorming:

-

O grupo precisa, antes de tudo, estar informado sobre os objetivos da sessão de brainstorming. O coordenador de cada grupo deve ter total domínio dessa metodologia.

-

O coordenador expõe o problema a ser discutido. Se necessário, divide-o em partes. Por fim, pede soluções para o problema.

-

O coordenador solicita que cada membro apresente apenas uma ideia de cada vez, e deve estimular cada ideia para provocar uma "reação em cadeia.

-

Os primeiros 10 a 15 minutos da sessão devem ser destinados ao bombardeio de ideias.

-

Um relator deve anotar todas as ideias sugeridas e preparar uma lista para rediscuti-las com os participantes.

-

A etapa seguinte é a seleção de ideias que pareceram mais promissoras. Se for o caso, devem -se fazer analogias ou adotar um sentido lógico.

-

As soluções escolhidas devem ser aglutinadas, coordenadas na definição do projeto e devidamente experimentadas.

Além disso, o Brainstorming pode ser classificado em dois tipos diferentes:

-

Brainstorming estruturado: é aquele no qual cada membro dá sua opinião a cada rodada. A grande vantagem é que os membros mais tímidos têm participação mais ativa, uma vez que possuem um momento apropriado para falar, não havendo uma completa dominância dos membros mais extrovertidos. A principal desvantagem é que há uma perda de dinamicidade em relação ao outro modelo;

-

Brainstorming não estruturado: neste tipo, cada pessoa pode dar sua opinião a qualquer momento, não havendo um momento específico como no modelo anterior. A grande vantagem é a maior dinamicidade do processo, pois as ideias vão se construindo umas sobre as outras. Por outro lado, por ser mais livre de regras de participação as pessoas tímidas e introvertidas tendem a contribuir pouco para o processo. Assim, este modelo é ideal apenas quando todas as pessoas do grupo possuem um perfil extrovertido.

5.13. DIAGRAMA DE CONCENTRAÇÃO DE DEFEITOS

Trata-se de uma figura da peça a ser produzida, representando graficamente todos os seus ângulos relevantes e se indicando na figura quais as regiões mais prováveis de acontecerem defeitos na produção da peça.

Um exemplo:

5.14. O 5S

O Ss é uma etapa fundamental para implementação de um programa de qualidade total nas organizações, uma vez que conscientiza, mobiliza e motiva as pessoas para que tenham organização e disciplina no próprio ambiente de trabalho.

O que se busca é a maior produtividade do funcionário em suas tarefas através de uma organização racional do ambiente de trabalho. São 5 elementos que devem ser considerados:

5.15. O CICLO PDCA .

O Ciclo PDCA é um ciclo de atividades contínuas que tem como objetivo a melhoria contínua da qualidade nas organizações, especialmente em processos organizacionais. Além disso, ele também busca criar normas para que processos com desempenho superior possam manter tais resultados através de um ciclo contínuo de previsão, avaliação e controle corretivo.

Tendo sido inicialmente concebido por Walter Shewhart na década de 1930, nos Estados Unidos, ele só foi popularizado por W Edwards Deming, durante o movimento da Qualidade Total, no Japão, cerca de duas décadas mais tarde. Seu desenvolvimento veio da percepção de que os problemas em um processo são oportunidades de melhoria causadas pela diferença entre o que os clientes dos processos precisam e o que o desempenho do processo ent rega. Assim, se o processo entrega coisas diferentes ou inferiores do que os clientes necessitam, surge uma oportunidade de melhoria no processo.

O Ciclo PDCA pode ser chamado também de Ciclo de Deming, Ciclo de Controle de Deming, Ciclo de Shewhart, Ciclo de Controle de Shewhart, Método de Melhorias...

O Ciclo PDCA consiste em uma sequencia de quatro funções básicas que devem ser repetidas continuamente:

-

Planejar (Plan)

-

Executar (Do)

-

Checar/ Verificar os resultados (Check)

-

Agir/ atuar corretivamente (Act ou Action ou Adjust)

A forma de visualização mais comum do Ciclo é a seguinte:

É importante saber a posição das letras no círculo?!

Resposta: Sim!

Uma versão mais detalhada do Ciclo PDCA apresenta as seis etapas seguintes, que nós temos que conhecer.

Vejamos detalhes sobre o ciclo PDCA:

-

Planejar (Plan)

É a fase das definições iniciais. É nela que os planos, objetivos, metas, recursos e métodos (etc.) a serem utilizados são definidos.

Pode-se dizer que esta fase consiste em duas etapas:

-

Definir as metas

Definir os métodos que permitirão atingir as metas propostas.Definir os As metas podem ter como objetivo melhorar o desempenho ou manter o desempenho de processos que já tenham um padrão elevado, criando padrões a serem atingidos.

Nesta etapa poderão ser utilizadas ferramentas como o Diagrama de lshikawa, o brainstorming, o Gráfico de Pareto, e o 5W2H. Não é nosso objetivo discutir cada uma dessas ferramentas, mas apenas saber que elas, ou outras, podem ser utilizadas nessa fase para auxiliar no planejamento e na tomada de decisão.Execução (Do).

-

Execução (Do)

É nessa fase que se executa o plano traçado na fase do planejamento.

Deve-se, em primeiro lugar, educar e treinar as pessoas envolvidas para que possa haver comprometimento e para que a execução saia conforme previsto. Em seguida, acontece a execução da tarefa propriamente dita e são coletados os dados a serem utilizados na etapa seguinte.

De forma sintética, pode-se dizer que esta fase possui as seguintes etapas:

-

educar e treinar;

-

Executar a tarefa (coletar dados).

-

Checagem dos resultados (Check)

Aqui os resultados obtidos pelas ações executadas na fase anterior são verificados. É fundamental que sejam utilizados os métodos adequados de verificação para evitar erros e consumo exagerado de recursos, em especial, do tempo. -

Agir corretivamente (Act)

Com base nas verificações ocorridas na fase anterior, são realizadas as ações corretivas necessárias sobre o processo considerado. Ao finalizar esta fase, inicia-se um novo ciclo através da fase de planejamento, constituindo a circularidade do Ciclo PDCA.

Outros autores podem apresentar formas diferentes de dividir as fases do PDCA, a depender do objetivo de sua aplicação, mas as 4 fases básicas serão sempre as mesmas.

Neste sentido , destaca-se a aplicação do ciclo PDCA no método chamado de QCStory, traduzido para o Brasil com o nome de MASP - Método de Análise e Solução de Problemas.

Trata-se de um método de solução de problemas introduzido no Japão na era da qualidade total pela JUSE (Japanese Union of Scientists and Engineers).

Trata-se de uma metodologia derivada da aplicação do ciclo PDCA da melhoria contínua da qualidade para resolver os problemas encontrados rapidamente, com base nos dados disponíveis e com o menor custo, sendo reconhecido por sua racionalidade ao lidar com a lógica e os dados disponíveis.

O MASP se baseia nas seguintes etapas:

-

Identificação do problema: definir claramente o problema e reconhecer sua importância.

-

Observação: investigar as características específicas do problema com uma visão ampla e sob diferentes pontos de vista.

-

Análise: descobrir as causas fundamentais.

-

Plano de ação: conceber um plano para bloquear as causas fundamentais.

-

Ação: bloquear as causas fundamentais.

-

Verificação: verificar se o bloqueio foi efetivo.

-

Padronização: prevenir contra o reaparecimento do problema.

-

Conclusão: recapitular todo o processo de solução do problema para trabalho futuro.

É importante lembrar que o MASP cria uma aplicação prática com base no ciclo PDCA (Planejamento, Execução, Verificação, Ação corretiva), por isso suas etapas podem ser associadas ao Ciclo, da seguinte forma:

Você pode observar esta relação também da seguinte forma:

Como você deve ter notado, trata-se apenas de uma forma visualmente diferente de representar as etapas do M ASP, ligando-as ao ciclo PDCA, mas o conteúdo é o mesmo que está apresentado na tabela!

Mesmo com nomes diferentes, percebam que as etapas têm uma pertinência lógica com as 4 fases essenciais do ciclo. Quando se fala em planejar, sabemos que é lá que os processos são identificados, observados, analisados e o plano de ação é feito. A ação e a verificação estão sem desdobramentos nesta representação, enquanto "agir corretivamente" passa a ser desmembrado em duas fases, sob este modelo: padronização e conclusão.

As perspectivas mencionadas acima são as mais comuns, mas certamente há outros autores que desdobram as fases de outras formas. O mais provável é que a banca do concurso cobre o Ciclo em sua forma mais básica, mas se não, provavelmente o fará de uma das formas que mencionei aqui.

É importante ainda destacar algumas variações modernas do PDCA, pois podem ser cobradas em sua prova.

O SDCA é a variação que começa com a padronização (Standardize), seguindo pelas etapas posteriores como no PDCA. Ele normalmente é aplicado após o PDCA, pois se realiza a padronização das melhorias, para depois seguir com um novo processo PDCA.

O PDCL é uma metodologia similar ao PDCA, exceto por destacar que a ação corretiva se dá por meio de aprendizagem (Learn) que retroalimenta o ciclo.

O PDSA, por sua vez, substitui o "Check" por "Study" , já que é necessário estudar o processo para que, uma vez compreendido, as devidas ações corretivas possam ser tomadas.

6. RESUMO

Diferentes visões acerca de Qualidade:

Na Abordagem transcendental: qualidade é o mesmo que excelência. Significa fazer o melhor que se pode fazer.

Abordagem baseada no produto: qualidade é uma variável que pode ser medida a partir dos atributos do produto.